Как настроить сайт для поисковиков, техническая оптимизация сайта.

Рассмотрим как делается техническая оптимизация сайта, как настроить сайт для поисковиков Google и Яндекс, SEO настройка с помощью элементов robots.txt, sitemap.xml, .htaccess. SEO сервисы, практические советы на примерах CMS joomla и Wordpress. Если есть затруднения, то мы предложим свои услуги.

Рассмотрим как делается техническая оптимизация сайта, как настроить сайт для поисковиков Google и Яндекс, SEO настройка с помощью элементов robots.txt, sitemap.xml, .htaccess. SEO сервисы, практические советы на примерах CMS joomla и Wordpress. Если есть затруднения, то мы предложим свои услуги.

SEO настройка сайта для поисковиков Google и Яндекс.

Прежде чем создать свой сайт, необходимо знать требования поисковиков Гугл и Яндекс к структуре и параметрам при поиске. Напомним, что основным критерием для поиска является качественный и уникальный КОНТЕНТ (содержимое). И не надо использовать методы, за которые можно попасть под фильтры. SEO факторы Яндекса и Google, лучше воспользоваться нашими услугами, про которые можно узнать здесь. Если уже он создан, то необходимо проверить SEO настройку сайта, а именно следующие основные параметры, влияющие на поиск в интернете:

- Основной адрес.

- Наличие мета тегов.

- Расстановка тегов заголовков в шаблоне.

На хостинге:

- Наличие и оформление robots.txt

- Наличие и правильная установка sitemap.xml.

- Наличие .htaccess.

Также

- Дубли страниц в поиске.

Далее рассмотрим, как настроить сайт для поисковиков, используя эти параметры.

Работа с этими пунктами и есть SEO настройка сайта для поисковиков или, грубо говоря, техническая оптимизация сайта и является первостепенным этапом SEO оптимизации.

ВАЖНО! Перед тем как начать работу по технической оптимизации и SEO настройке сайта для поисковиков, обязательно необходимо сделать РЕЗЕРВНУЮ КОПИЮ САЙТА или хотя бы те файлы, которые будут редактироваться сохранить на компьютер, чтобы в случае нарушения работы восстановить сайт!

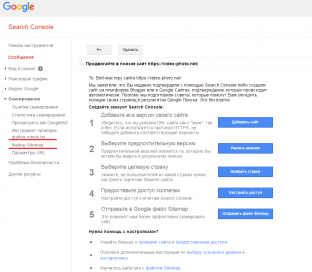

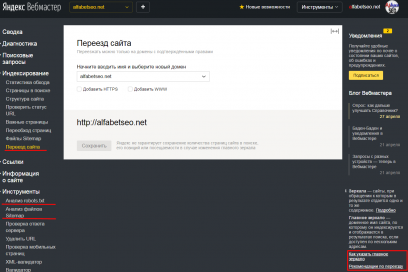

Вебмастера Яндекс и Гугл.

Рекомендуется привязать сайт к Яндекс вебмастеру и Инструментам для вебмастеров Google. Выполнить все рекомендуемые действия, такие как указать основной адрес (с www, https или без них), проверить файлы robots.txt, sitemap. Воспользоваться советами и инструкциями. Впоследствии использовать их (проверять ошибки, оповещения, отправлять в индекс гугл и пр.).

Проверка и настройка основного адреса сайта, htaccess.

После регистрации домена необходимо определи основной адрес, по которому будет сайт работать в поиске. Домен может работать с WWW. и без этой части. Например: WWW.SITE.RU и SITE.RU. Это для поисковиков два разных сайта. Если не сделать один из этих адресов основным, то поисковики будут вместо одного видеть два сайта с одинаковым контентом. Это существенно влияет на поисковую выдачу. Проверить это можно введя адреса доменов с www и затем без в адресную строку браузера и посмотреть как изменился адрес после загрузки сайта. Если в обоих случаях генерируется один адрес (либо с www, либо без), то ничего настраивать не надо. Если сайт работает по двум адресам, необходима настройка.

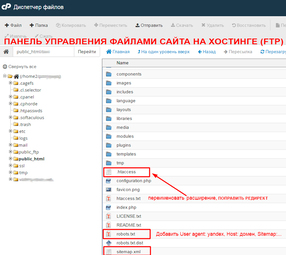

Настроить основной адрес можно с помощью файла .htaccess. После соответствующей настройки он дает команду на перенаправление с адреса с www на адрес без www и, наоборот, в зависимости от настройки редиректа. Он обычно находится в корне сайта в директории (папке) www. Сразу необходимо заметить, что в некоторых CMS (движках), например в Joomla, этот файл может находиться с текстовым расширением htaccess.txt. Исправить это можно следующим образом. Скачать с хостинга (можно с помощью ftp клиента Filezilla или другого, или сразу на хостинге, если панель управления файлами хостинга имеет такую возможность) и переименовать расширение (тип) с htaccess.txt на .htaccess, и обратно закачать на хостинг. Для сайтов с https выбор основной версии сайта в Search Console Google просходит после добавления и подтверждения прав на сайт с 4 версиями (с http (с www и без) и с https (с www и без).

Как настроить редирект?

ВНИМАНИЕ! ЗДЕСЬ ОЗНАКОМИТЕЛЬНО ПРЕДСТАВЛЕН ОДИН ИЗ ВАРИАНТОВ. СОДЕРЖИМОЕ ФАЙЛА МОЖЕТ ЗАВИСИТЬ ОТ РАЗЛИЧНЫХ ПАРАМЕТРОВ, В ТОМ ЧИСЛЕ ОТ ХОСТИНГА. ЭТО НАДО УТОЧНЯТЬ.

.htaccess для редактирования содержимого можно открыть с помощью блокнота или лучше с помощью программы Notepad. В содержимом после

RewriteEngine On

надо записать следующее:

Редирект с site.ru на www.site.ru.

RewriteCond %{HTTP_HOST} ^site\.ru

RewriteRule ^(.*)$ http://www.site.ru/$1 [R=permanent,L]

Редирект с www.site.ru на site.ru.

RewriteCond %{HTTP_HOST} ^www\. site \. ru

RewriteRule ^(.*)$ http:// site. ru /$1 [R=permanent,L]

или Редирект с site.ru на www.site.ru.

RewriteCond %{HTTP_HOST} !^www\.site\.ru [NC]

RewriteRule ^(.*) http://www.site.ru/$1 [R=301,L]

Редирект с www.site.ru на site.ru.

RewriteCond %{HTTP_HOST} ^www.site.ru

RewriteRule ^(.*)$ http://site.ru/$1 [R=301,L]

Немаловажную роль играет представление домена в поиске со слешем в конце. Здесь мнения разделяются. Как правильно site.ru или site.ru/. рекомендуется со слешем в конце. Тогда поисковик будет знать, что это не одна страница, а у домена есть еще каталог категорий и страниц. Проверить, как показывается домен, со слешем в конце или нет, можно вставить адрес домена без слеша в адресную строку браузера. Там сгенерируется вид данного домена. Если адрес без слеша на конце, то можно в файл .htaccess вставить код:

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_URI} !(.*)/$

RewriteRule ^(.*)$ /$1/ [R=301,L]

Также в .htaccess можно настроить редирект, позволяющий убрать дубли страниц. Обычно дубли содержат часть адреса index.php. Как вариант, убрать его можно с помощью кода (возможны другие варианты):

RewriteEngine On RewriteRule ^index.php$ / [QSA,R]

Настройка мета тегов.

В основном, во всех движках в наличии поля для заполнения тега title и мета тегов description и keywords (Они могут называться описание и ключевые слова, соответственно). Но в популярной бесплатной CMS Wordpress по умолчанию полей в редакторе страниц и записей нет. Для этого надо дополнительно устанавливать seo плагины. Как настроить Wordpress для поиска, читаем здесь. Для движка Joomla тут. Для Opencart на этой странице.

Главный тег для поиска title обычно генерируется от названия сайта и страниц или же его можно писать вручную с помощью seo плагинов (расширений к системе управления контентом). Если Яндекс пока description не воспринимает, то для Гугла это один из важнейших тегов для поиска.

Как настроить мета теги - читаем здесь.

Настройка тегов заголовков.

Очень часто в структуре шаблонов разработчики присваивают теги заголовков различным элементам сайта. Но они должны присутствовать в разметке статьи. Причем тег заголовка h1 на странице должен присутствовать только в единственном экземпляре. Основное внимание надо уделить h1 и подзаголовку h2, так как они более значительны для оптимизации. Нередко h1 обрамляет логотип сайта, а подзаголовки h2, h3 генерируются в названии структурных частей сайта (модулей, виджетах, плагинах). Например, они обрамляют такие дополнения как контакты, виджеты соц. сетей и другие элементы структуры дизайна. Проверить их наличие и расположение можно следующим способом: нажать правой кнопкой мыши на страницу в браузере и выбрать посмотреть код страницы или исходный код (в зависимости от браузера) и проверить какой тег какому структурному заголовку присвоен (для удобства нажать сочетание клавиш Ctrl+F и в появившемся окошке поиска ввести нужный запрос, например h1). Не надо нажимать правой кнопкой на изображениях и флеше, выйдет другое меню. Бывают случаи, когда в шаблоне присутствуют сразу несколько h1. Настройку вывода заголовков в шаблоне надо исправлять в коде. По этому, когда создаете сайт самостоятельно или заказываете шаблон у дизайнера, обращайте внимание на наличие этих тегов. Простейшим способом решения проблемы ненужных заголовков является их удаление или замена на div в коде структурных компонентов шаблона. Без соответствующих знаний это делать самому не рекомендуется, можно навредить. Лучше обратиться к специалистам.

Настройка и оформление файла robots.txt.

Этот файл также играет значительную роль для поиска. Он показывает поисковым роботам, какие ссылки запрещено индексировать в поиске. С его помощью можно предотвратить появление в поисковой выдаче технические и другие не нужные ссылки, например ссылки дублей страниц. Для каждого сайта свой robots.txt. Его составление и настройка должна осуществляться специалистами. Можно работоспособные варианты найти в интернете на тематических для движка сайтах. В интернете много стандартных, общих вариантов для различных движков. Как настроить этот файл? В некоторых движках robots.txt предустановлен. Главное условие, чтоб robots.txt был настроен для Яндекса в том числе. Минимальный набор кода для поисковых систем в robots.txt:

User-agent: * Disallow: .....

.........

Sitemap: http:// site.ru/sitemap.xml

User-agent: Yandex

Disallow: .....

..........

Host: site.ru

Sitemap: http:// site.ru/sitemap.xml

Где site.ru – Ваш домен, а Sitemap: http:// site.ru/sitemap.xml – путь к карте сайта.

(С недавнего времени Яндекс заявил, что директиву Host можно не указывать, т.к. основная версия сайта указывается в Яндекс вебмастере).

В большинстве случаев посмотреть содержание robots.txt в браузере можно вставив через слеш после адреса домена robots.txt - http:// site.ru/ robots.txt.

При использовании плагина генерации сайтмап для движка Joomla – OSmap, путь к карте сайта примерно следующий:

http://site.ru/index.php?option=com_osmap&view=xml&tmpl=component&id=1

Посмотреть этот путь можно непосредственно в плагине OSmap.

Владельцы Wordpress должны быть внимательны. При оптимизации и установке этого движка с помощью некоторых SEO плагинов, например All in One SEO pack, при включении функции robots.txt может возникнуть следующая ошибка. По умолчанию может сгенерироваться следующее:

User-agent: * Disallow: /

Со слешем! Это запрет индексации всех страниц кроме основного адреса. Поэтому надо проверять этот файл и настроить, удалив слеш в конце.

Есть онлайн сервисы, предлагающие автоматическую генерацию robots.txt, где самостоятельно вручную можно задавать адреса, запрещенные к индексированию, но рекомендуется, чтоб его составляли специалисты, особенно для больших сайтов, интернет магазинов и каталогов, т.к. необходимо учитывать дополнительные плагины, присутствующие на сайте.

Загрузка файла на хостинг аналогично как показано в случае с htaccess выше.

Установка и настройка карты сайта sitemap.

Карта сайта sitemap.xml нужна для указания поисковым роботам адресов страниц для индексирования. Особенно он нужен для многостраничных ресурсов, где часто добавляются новые статьи. Этот файл позволяет ускорять индексацию и переиндексацию при изменениях контента. Для этого при настройке robots.txt необходимо указывать путь к нему, как описано выше. Роботы будут периодически посещать указанные ссылки, и перечитывать содержимое. Настраивать его самостоятельно новичкам не рекомендуется. Существуют как плагины, автоматически генерирующие sitemap.xml для существующих и вновь добавленных статей для различных движков, так и онлайн сервисы, в которых достаточно указать домен. Очень удобны сервисы с дополнительным формированием сайтмапа в виде HTML, что позволяет создать страницу с картой сайта для удобства поиска необходимого контента посетителями. Некоторые плагины, которые позволяют это сделать: для Joomla – вышеупомянутый OSmap, для Wordpress - SEO плагин от Yoast или же плагин All in One SEO pack. Эти плагины также необходимо правильно настроить.

В онлайн режиме рекомендуется сервис xml-sitemaps.com, позволяющий сгенерировать файлы в различных форматах, но до 500 страниц. Загрузка файла на хостинг аналогична вышеописанным примерам.

Дубли страниц.

Дубли страниц, это, наверное, основная проблема для поиска. Большинство движков генерирует дубли и они появляются в поиске. Для поисковых систем это большой минус, так как они не могут определить какая же страница необходима для поиска из нескольких адресов с одинаковым контентом. В результате позиции в поиске падают.

Как найти дубли?

Простейший способ - это вбить в строку поиска кусок текст статьи, в Гугл предварительно заключив его в кавычки, и нажать поиск. Если этот текст выходит по нескольким адресам – это дубли. Их можно так же определить с помощью инструментов вебмастеров Гугл. Для этого открываем Вид в поиске – оптимизация HTML – и смотрим повторяющиеся описания и повторяющиеся теги заголовков. Среди приведенных ссылок них могут быть дубли. Еще один способ – при проверке позиций в специализированных сервисах могут выйти результаты не по тем адресам, это возможно тоже дубли.

Исправить это можно с помощью настройки вышеперечисленных файлов и вручную. В файле robots.txt обозначаются ссылки, запрещенные к индексации, в .htaccess создается редирект с дубля ссылки на основной адрес для поиска. Не нужные дублированные ссылки можно удалить из индекса Гугл в инструментах вебмастеров Google в разделе Индекс Google – Удалить URL адреса – Создать новый запрос на удаление – вносим адрес ссылки. Запретить дубли можно с помощью настройки мета тега в коде дубля страницы:

<meta name="robots" content="noindex,nofollow"/>

или тега

<link rel="canonical" href="/основной адрес" />

ВАЖНО! Одновременно нельзя использовать запрет в robots.txt и в мета тегах.

Распространенной ошибкой является генерирование дубля главной страницы сайта. Здесь ошибка может возникнуть помимо вышеописанных (с www, со слешем в конце). При возвращении на главную с других, ссылка главной может содержать элемент index.php, может с приставкой main, glavnaia и т.д. Это может возникнуть из-за неправильных настроек сайта, применения различных плагинов и прочее. Для каждого сайта причина может быть своя и решать ее можно либо вышеперечисленными методами, либо искать решение в настройках кода движка. Опять же, лучше это доверить специалистам, которые точно знают, как настроить те или иные параметры.

После проведения SEO настройки сайта для поисковиков путем технической оптимизации движка, можно приступать к дальнейшей внутренней оптимизации: подбор и расстановка ключевых слов, оптимизации статей, перелинковка. Только потом уже приступать к внешней оптимизации.